考慮一個機器學習、統計中常常會遇到的一個convex optimization問題

(LASSO) 問題 (Least Absolute Shrinkage and Selection Operator)

where

令

問題(1) 可以簡化成

將

問題(2) 的constraint 也可以改寫成

where

我們用問題(3) 當作起點開始推導

根據 norm 定義展開:

其中

也就是說,對於每一個 component 我們可以獨立求解

對每個分量微分:

其中絕對值無法直接微分,所以用subdifferent取代

假設

if 有變數

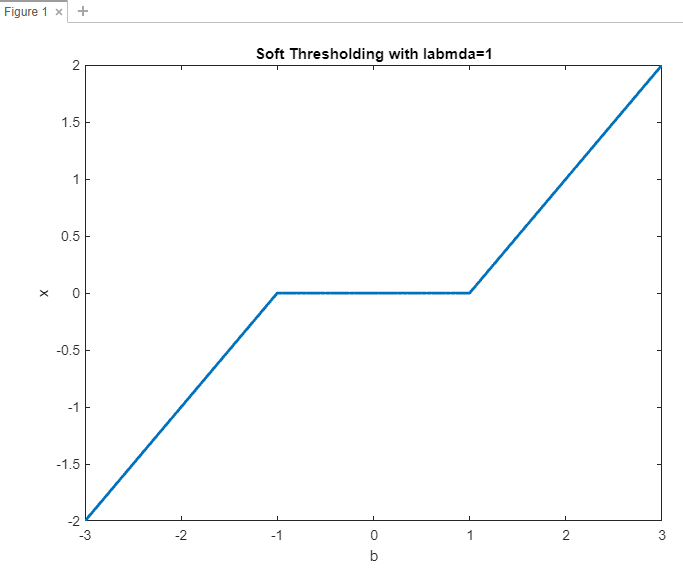

以上公式被稱為 Soft Thresholding

又因為這個是convex function,當極值發生時,就是微分=0的解,所以我們推出了這個LASSO 的closed form solution。

現在將

以下是以縱坐標為

這個圖形水平線的寬度與

可以將 (4) 式改寫,將 soft thresholding

看成一個運算子(opeator),這個運算子就代表著求解問題(3),取名為

改寫成

這個運算子計算非常簡單,只需要比較

也就是只根求解的向量

對應於【軟】閾值 Soft Thresholding 也有【硬】閾值 Hard Thresholding 這兩個是很類似的主題,之後有空也會在整理一篇。

Reference

http://weixingsong.weebly.com/uploads/7/4/3/5/7435707/stat905_lecture5.pdf

https://xavierbourretsicotte.github.io/lasso_derivation.html